Meta sta lavorando a un nuovo strumento per tutelare gli utenti dal «sextortion» e dall’«abuso di immagini intime» su Instagram. In particolare, come ha annunciato la big tech giovedì 11 aprile, la piattaforma vuole testare un sistema che protegga soprattutto i minori da «contatti indesiderati e potenzialmente dannosi».

Che cos’è il sextortion

Il sextortion è una forma di estorsione online. Gli scammers – i ricattatori – individuano le potenziali vittime attraverso i social network, contattandole e coinvolgendole in una conversazione. A un certo punto, propongono di scambiarsi fotografie o video intimi. Oppure, di passare a una piattaforma di videochat su cui le vittime sono convinte a spogliarsi e compiere atti sessualmente espliciti. Questi gesti sono segretamente registrati e utilizzati, come i materiali inviati dalle stesse vittime, per ricattarle, minacciandole di rendere pubbliche sia le loro immagini che le loro identità.

Cosa cambia su Instagram

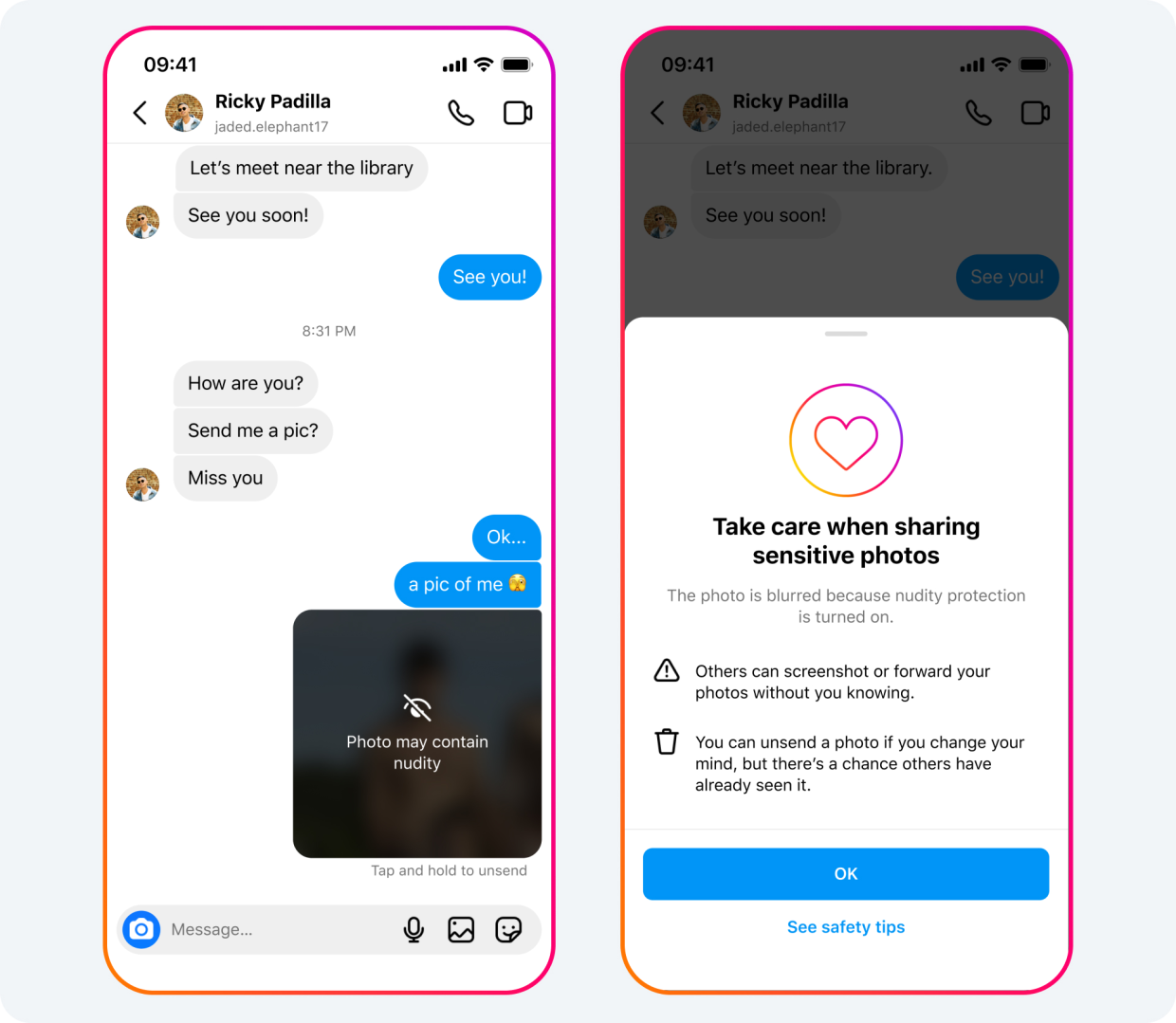

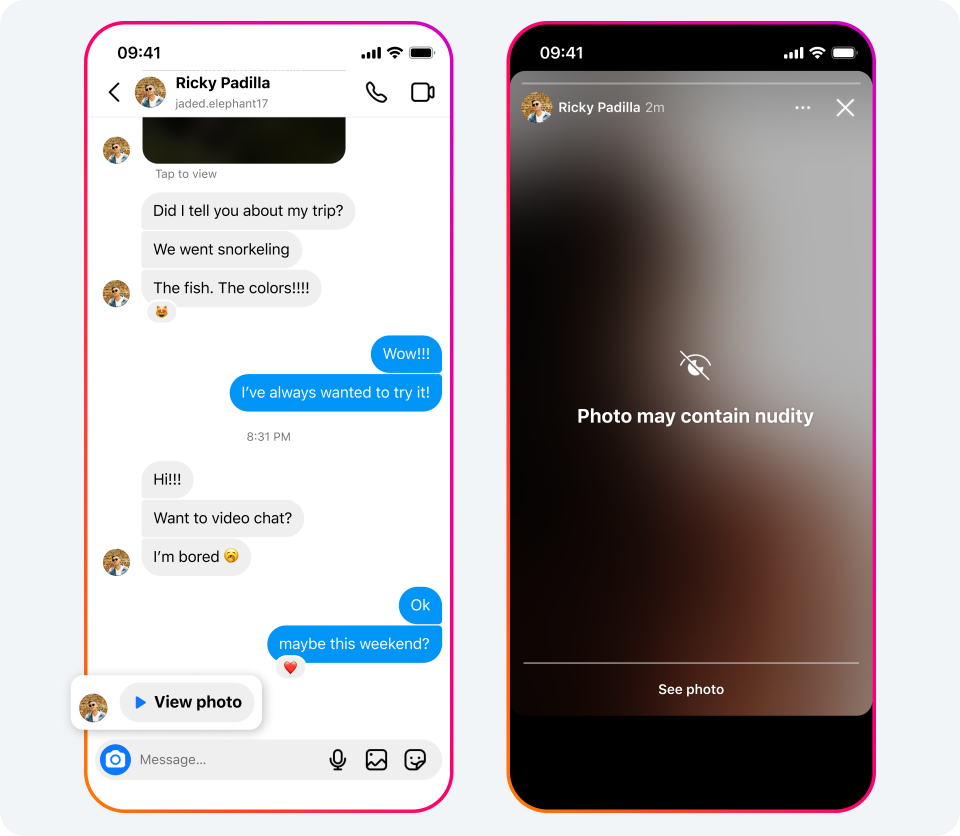

I Direct Messages (DM), i messaggi privati di Instagram, sono utilizzati dai sextortion scammers per condividere o chiedere contenuti intimi e ricattare le proprie vittime. La barriera di protezione che Meta sta studiando permetterà di oscurare con un blur immagini di nudo, come già accade con fotografie e video classificati come violenti. A questo si aggiunge una seconda barriera, un avviso che incoraggerà gli utenti a «a pensarci due volte» prima di inviare contenuti compromettenti.

Come ha spiegato Meta, questo strumento sarà impostato di default, a livello mondiale, sugli account degli utenti che hanno meno di 18 anni. Mentre i maggiorenni riceveranno una notifica per spingerli ad attivare la protezione.

Come funziona il sistema di protezione

A chi dovesse inviare un’immagine di nudo apparirà un messaggio per ricordare «di essere prudenti» e per avvisarli che «possono annullare l’invio se hanno cambiato idea». Lo stesso vale per gli utenti che volessero inoltrare un contenuto mandato da altri.

I materiali sensibili saranno automaticamente oscurati attraverso un blur, dando la possibilità a chi li riceve di scegliere se visualizzarli.

Per implementare questa funzione, la piattaforma utilizzerà sistemi di «apprendimento automatico per analizzare se un’immagine inviata in un DM su Instagram contiene nudità», ha spiegato Meta. L’azienda statunitense ha precisato che questo avviene nelle chat crittografate end-to-end del singolo dispositivo, perciò la società non avrà accesso ai contenuti sensibili a meno che non siano segnalati dall’utente.

Parallelamente, Meta ha annunciato che sta lavorando a tecnologie in grado di identificare gli account potenzialmente coinvolti in attività di sextortion, in modo da rimuoverli e impedire ai ricattatori di creare nuovi profili.

Rimozione di contenuti: il caso di Radio Maria

Come già stabiliscono le linee guida di Instagram, la piattaforma rimuove immagini di nudo, illegali, che mostrano violenza esplicita, incitano all’odio o incoraggiano atti di autolesionismo. «Abbiamo rimosso il tuo contenuto. Sembra che tu abbia condiviso o inviato immagini di nudo o atti sessuali» è il messaggio che segnala agli utenti quando un loro post non rispetta le linee guida del social network.

L’algoritmo, però, non sempre valuta correttamente tutti i contenuti. È il caso della diretta Facebook di Radio Maria in occasione della Via Crucis di venerdì 29 aprile. L’intelligenza artificiale di Meta avrebbe classificato come contenuto di nudo l’immagine del Crocifisso, inquadrato in diretta mentre l’emittente trasmetteva la registrazione di una celebrazione organizzata a Medjugorje alcuni anni fa. Prima, il post è stato cancellato. Poi, Radio Maria l’ha pubblicato nuovamente, ma sembrerebbe che Facebook abbia imposto delle limitazioni: «Avevamo seicento persone che seguivano la diretta e sono diventate una ventina, come se fossero state messe delle restrizioni», ha sottolineato la caporedattrice Roberta Zappa.