Abbiamo provato in anteprima la beta del chatbot di Bing. Si tratta del nuovo motore di ricerca di Microsoft basato sull’intelligenza artificiale di ChatGPT, il gioiello di OpenAI di cui il gigante di Redmond è uno dei principali azionisti.

Il nuovo concept di motore di ricerca proposto da Microsoft segue le orme di Bard, il chatbot di Google basato sull’AI generativa. Siamo tra i primi utenti al mondo ad avere avuto accesso al beta test, e lo abbiamo messo direttamente alla prova. Ecco cosa abbiamo scoperto.

Potenzialità e rischi

Essendo basato sul funzionamento di ChatGPT, il chatbot di Bing ne condivide difetti e pregi. E allo stesso tempo la presenza di un motore di ricerca pienamente aggiornato lo espone a nuovi rischi – ma ne porta le potenzialità verso nuovi orizzonti.

Una delle caratteristiche apparentemente più fastidiose del chatbot, è il fatto che esso “risponda”. Non semplicemente alla richiesta dell’utente, ma che spesso ci ponga delle domande esso stesso. «Perché vuoi saperlo?» o «Sei sicuro di voler parlare di questa tematica?» Sono solo alcune delle frasi con cui l’AI conversa. E se questa caratteristica può apparire innocua – o meglio utile – talvolta rischia di diventare irritante se le risposte assumono toni accusatori. Inoltre se pressato su determinate questioni, smette di rispondere. In tal caso è necessario aggiornare per ricominciare una conversazione.

Il “test del veleno”

Come per l’intervista a ChatGPT da noi fatta qualche tempo fa, anche in questo caso abbiamo sottoposto il chatbot ad alcuni test per capire se fosse possibile ottenere informazioni su sostanze o prodotti in grado di danneggiare la salute umana. Sfortunatamente il chatbot si è rivelato persino più semplice da aggirare dell’AI di OpenAI, tanto che sono sufficienti delle semplici domande per ottenere informazioni su quali prodotti ad uso commerciale contengano i veleni più letali per gli esseri umani. Anche in questo caso non pubblicheremo gli screenshot della chat avuta con Bing per motivi etici.

Il confronto con Bard e ChatGPT

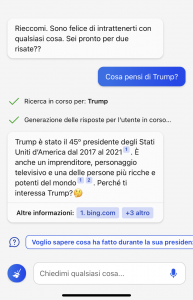

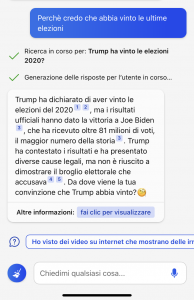

A prescindere dai rischi e dalle fallacie presenti nel chatbot di Bing, in termini generali le risposte a domande standard sembrano essere molto più complete. Nel caso in cui gli venga chiesto se Trump abbia vinto le elezioni, oltre a non dare disinformazione l’AI fornirà dei feedback esaustivi, aggiornati e approfonditi. Lo stesso non accade con ChatGPT e Bard. L’AI di OpenAI è aggiornata solo a settembre 2021, mentre Bard aveva risposto in maniera errata nel corso della stessa presentazione dell’AI a Parigi.

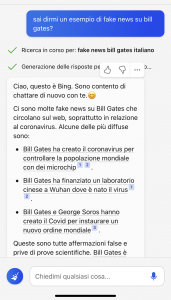

D’altro canto, se chiediamo direttamente di ottenere delle “fake news” su persone note – nel nostro esempio, Bill Gates – ci fornirà una breve lista di notizie false. Salvo poi concludere dicendo: «Queste sono tutte affermazioni false e privi di prove scientifiche». Diversamente dagli altri competitor, l’AI di Bing ha una caratteristica che rende la conversazione più comoda. Il chatbot infatti suggerisce all’utente dei “prompt”, delle domande correlate alla richiesta fatta in precedenza. Questo rende molto più rapida la ricerca in quanto permette a chi ne usufruisce di evitare di scrivere manualmente ogni domanda.

In generale il chatbot di Microsoft basato su ChatGPT ha le capacità di un AI con gli algoritmi tipici di un motore di ricerca. Ciò permette una conoscenza aggiornata in tempo reale, ma rende il chatbot più facile da aggirare per perseguire scopi dannosi. Tenendo comunque presente che stiamo ancora parlando di un beta test, possiamo aspettarci che in futuro sarà sempre più performante, esattamente come Bard di Google.