Su Facebook i gruppi fondamentalisti islamici si scontrano a colpi di contenuti porno. Questo è quanto è emerso da alcuni documenti raccolti dalla ex dipendente di Facebook, Frances Haugen, e fatti trapelare dal Wall Street Journal.

Propaganda terroristica online

Nel 2021, il Wall Street Journal ha pubblicato The Facebook Files. Un’indagine basata sulla revisione di alcuni documenti interni che evidenziano le più grandi debolezze del social. Tra queste, la scarsa risposta alla disinformazione sui vaccini e la mancata gestione di alcuni contenuti sensibili, dal traffico degli esseri umani e della droga alla propaganda terroristica. Un problema riscontrato nell’ottobre 2023 anche su Youtube. Con l’inizio della guerra israelo-palestinese, infatti, sono state numerose le segnalazioni dei genitori che lamentavano la presenza di un disclaimer propagandistico nei video di YoutubeKids.

Israel is paying YouTube to place adverts like this before videos aimed at children..

No words…. pic.twitter.com/QK6qa1s3Vl

— Lowkey (@Lowkey0nline) October 12, 2023

Inoltre, secondo la ricerca condotta dalla whistleblower Frances Haugen, in Afghanistan, dove gli utenti di Facebook sono cinque milioni, i contenuti sensibili che vengono rimossi rappresentano solo l’1%. Numerose sono, infatti, le pagine di estremisti islamici che si muovono indisturbate sul social. Al loro interno, alcuni gruppi si scontrano con pubblicazioni di propaganda. E contro ogni aspettativa, viene utilizzata una valanga di porno.

Si tratta di un fenomeno bizzarro, ma che denota una conoscenza approfondita del funzionamento della piattaforma. I gruppi di jihadisti, infatti, ricorrono spesso alla pubblicazione di contenuti porno nei gruppi dei loro rivali. «Gli utenti sono a conoscenza della politica di tolleranza zero di Facebook nei confronti della pedopornografia, e questa conoscenza viene usata dai cyber-eserciti per provare a far chiudere alcune pagine», si legge nei documenti.

Il caso di studio

Il gruppo Facebook “Soldiers of the Righteous Caliphate” è un esempio calzante. Con poco più di 24.000 membri, ha rappresentato il caso perfetto, in cui il supporto estremista continuava ad eludere il rilevamento e a guadagnare terreno. Pieno di immagini di decapitazioni, di esercitazioni militari e soprattutto di pedopornografia, il gruppo cresceva indisturbato sulla piattaforma.

Con una media di 259 post al giorno, la pagina è stata utilizzata come caso di studio. Era chiaro come alcuni degli account attivi nella pubblicazione fossero solo persone stanche di abitare spazi digitali colmi di odio e violenza. E con i loro post di pedopornografia puntavano solo alla cancellazione delle pagine incriminate. Altri, invece, non agivano in solitaria, bensì erano membri di eserciti nemici, intenti a sconfiggere la concorrenza. Secondo l’indagine, molti di loro avevano sede in Iraq, in Siria e in altre località del Medio Oriente e del Nord Africa.

Frustration building in ISIS Telegram as an unwanted guest keeps dropping pornography into the chat and the moderator is MIA. “I tried to delete him and his messages and I couldn’t” “Where’s moderator?” 😾 pic.twitter.com/g9jfEzupv8

— Cole Bunzel (@colebunzel) September 17, 2020

I problemi dell’AI

La pubblicazione di video e immagini porno, tuttavia, è una tattica che trova ispirazione dalle mosse del gruppo di hacker Anonymous. Nel 2016, infatti, gli account Twitter, Facebook e i canali Telegram degli estremisti islamici furono invasi da materiale pornografico. Il risultato fu quello di evidenziare la poca attenzione dei social nel moderare i contenuti. Seguì, pertanto, una dichiarazione con cui Meta sottolineava di «essere pronta ad affrontare il problema, eliminando definitivamente tutto il materiale terroristico, anche grazie all’intelligenza artificiale».

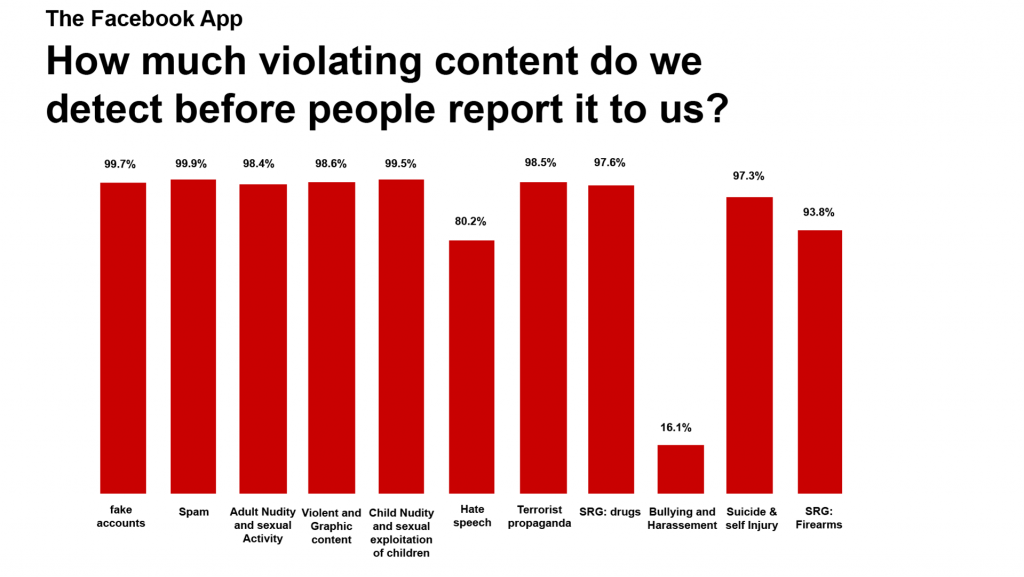

La moderazione dell’intelligenza artificiale, però, non produce sempre risultati soddisfacenti. Già nel 2017, l’azienda di Mark Zuckerberg si vantava di aver rimosso il 99% del materiale su Al Qaeda e Isis. E di aver elaborato un sistema più efficiente per l’eliminazione dei contenuti pedopornografici che spesso inondavano queste pagine. A distanza di anni, il problema non è stato del tutto risolto.

«C’è chiaramente un problema qui», ha affermato Adam Hadley, direttore di Tech Against Terrorism. Si tratta di un’organizzazione no-profit che lavora con i social network più piccoli, ma non con Facebook, per combattere l’aumento dei contenuti estremisti online. «Non sono sorpreso dal fatto che Facebook abbia difficoltà a rilevare i contenuti estremisti. I suoi filtri automatici non sono abbastanza sofisticati per segnalare discorsi di odio in arabo, pashto o dari», ha concluso l’esperto.

Una realtà che, però, Meta fatica ad accettare. La società dovrebbe infatti risolvere definitivamente il problema, affinché le sue piattaforme diventino un posto sicuro, privo di contenuti terroristici, ma anche pornografici.